Childlike airbrush style // Обучение генеративной нейросети

Идея проекта

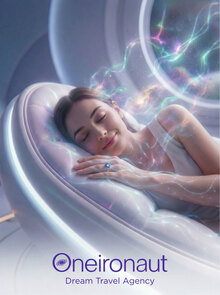

Я очень люблю иллюстрации и абстрактное творчество. В последнее время меня особенно вдохновляет стиль airbrush его мягкость, светлость и почти ощутимая атмосфера.

К сожалению, у меня нет ни времени, ни возможности глубоко изучать эту технику, однако мне очень хочется создавать что-то похожее и использовать этот стиль в своих работах.

Главная цель моего проекта: проверить, насколько точно нейросеть сможет уловить мои пожелания и передать эстетику, которая кажется мне близкой, но при этом необычной для обычного восприятия.

*изображение из Pinterest

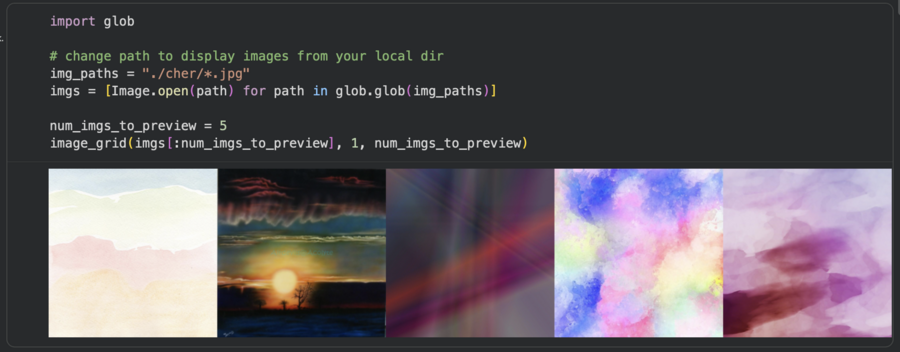

Была собрана папка с изображениями, которые служат прямыми референсами к нужному стилю. Среди них попадались работы разных художников, но их я не использовала, чтобы не нарушать авторские права.

Референсы собраны в разных направлениях так, чтобы из большой выборки можно было сформировать собственное, уникальное визуальное видение.

Однако основная цель проекта остаётся прежней, максимально точно попасть в эстетику и стилистику airbrush.

Использованные инструменты:

— Stable Diffusion — обучение генеративной нейросети под свой стиль; — Google Colab — выполнение кода и генераций; — Hugging Face — получение токена для обучения нейросети, загрузка полученной модели на сайт; — Adobe Photoshop — для коллажирования готовых работ; — Chat GPT — грамматическая и стилистическая редактура текстов проекта.

Описание процесса работы

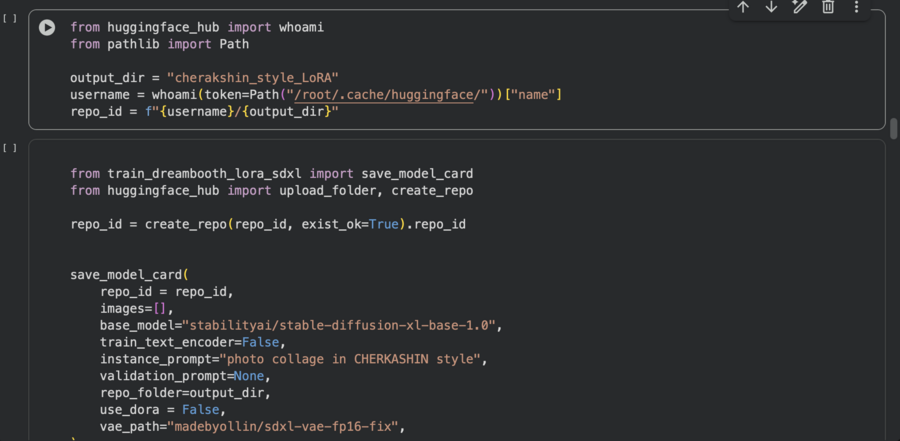

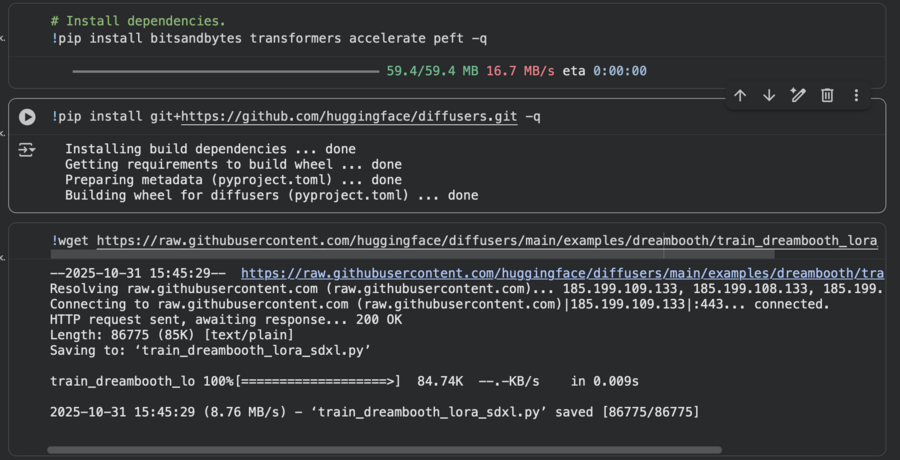

Первостепенно скачала необходимые библиотеки: bitsandbytes, transformers, accelerate, peft и затем diffusers из репозитория (через pip install git+https://github.com/huggingface/diffusers.git). Это подготовило окружение для обучения SDXL + LoRA / DreamBooth.

Затем был скачен тренировочный скрипт DreamBooth/LoRA для SDXL (train_dreambooth_lora_sdxl.py) из репозитория Diffusers, он содержит логику подготовки датасета и запуск обучения с LoRA.

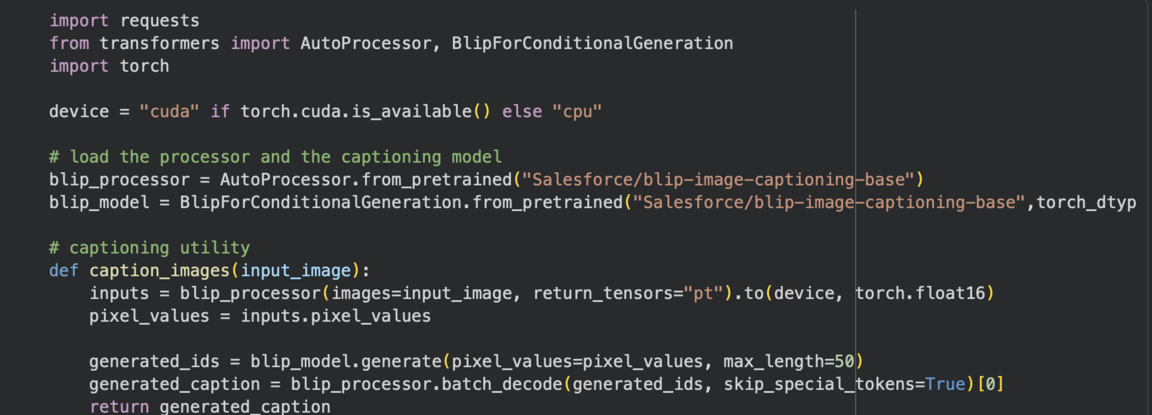

Для автоматической генерации подписей к изображениям загрузила и использовала модель BLIP (Salesforce/blip-image-captioning-base). Реализовала функцию caption_images (input_image), которая возвращает автогенерированный caption для каждого изображения.

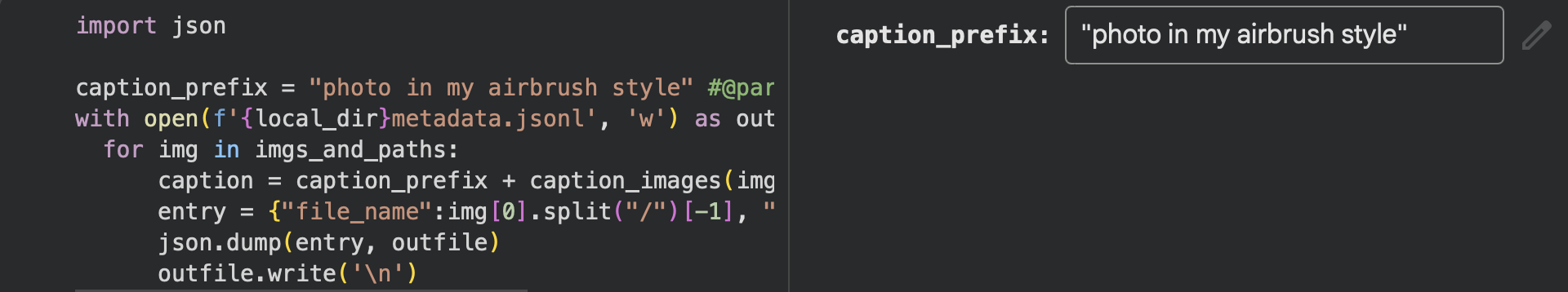

После этого каждому изображению в каталоге добавила префикс подписи caption_prefix = «photo in my airbrush style» и объединила префикс + результат BLIP в одну строку. Эти записи сохранялись в metadata.jsonl в тренировочном metadata-файл.

Далее определила гиперпараметры обучения (в ноутбуке они вынесены в markdown/скрипт запуска).

Запуск обучения производила через! accelerate launch train_dreambooth_lora_sdxl.py… с перечисленными выше флагами.

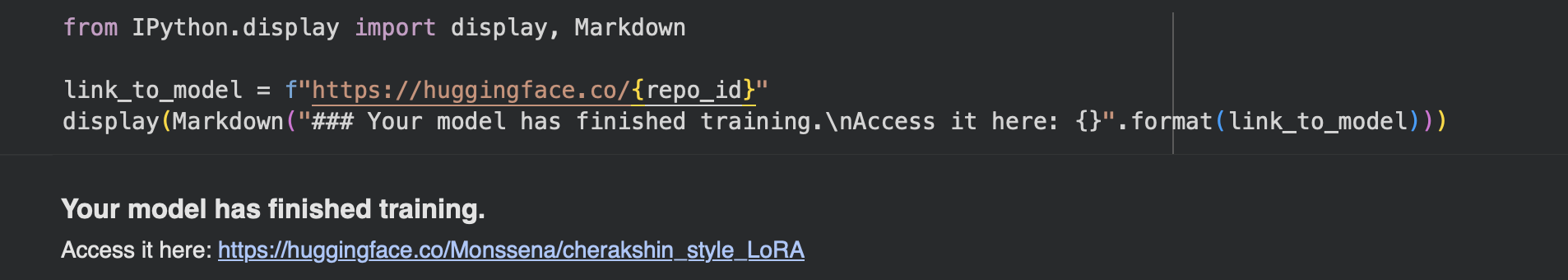

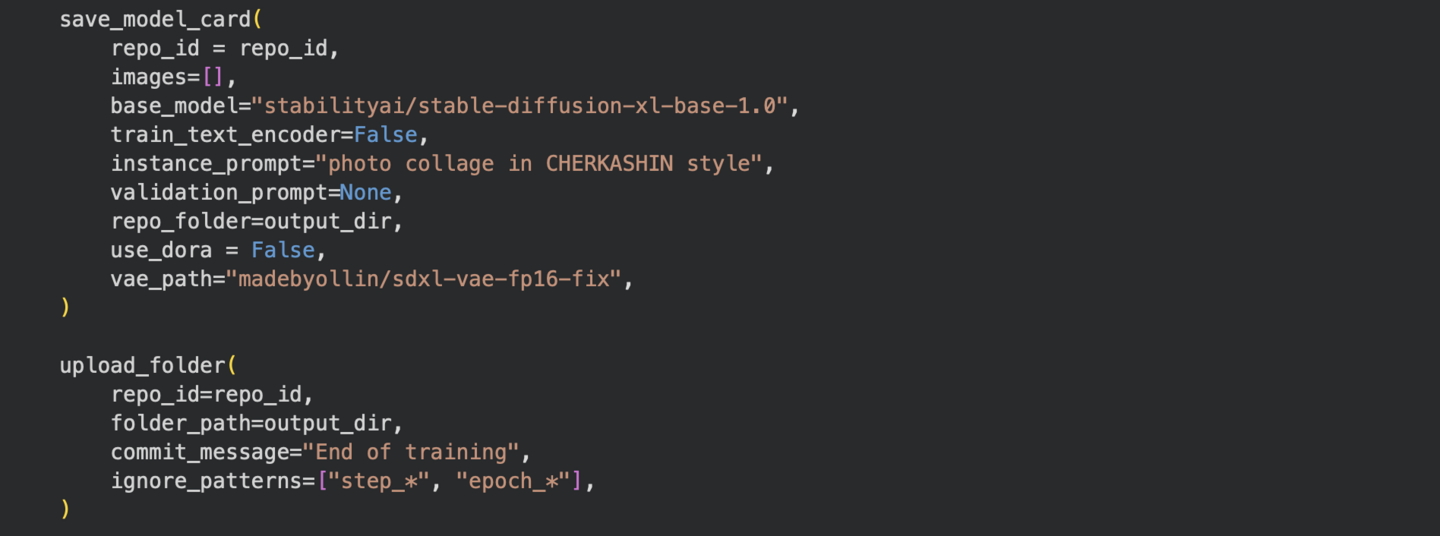

По завершении скрипта модель/LoRA сохранялась в папке --output_dir="cherakshin_style_LoRA»; в дальнейшем результат был загружен на Hugging Face Hub (через токен и upload_folder).

Тестовые генерации: после тренировки загружала LoRA/модель в pipeline и пробовала промты типа «still life of flowers in airbrush style…», «realistic starry night sky with soft glowing stars…» и т. п., с параметрами генерации num_inference_steps=30, guidance_scale=8.0.

Промт: still life of flowers in airbrush style, soft transitions between colors, smooth shading, glowing accents

Первые генерации

Изначально при первых генерациях результаты получались слишком яркими и больше напоминали абстракцию, чем стиль airbrush. Кроме того, изображения не имели единой стилистики каждое выглядело по-своему, без общей визуальной логики.

prompt = «peaceful lake surrounded by mountains, soft reflections on the water, airbrush-style gentle ripples, smooth gradient sky blending with vibrant sunset colors»

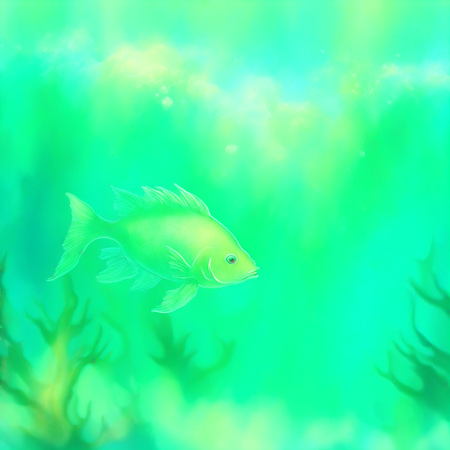

prompt = «underwater scene with glowing fish, soft airbrush textures on the ocean floor, smooth gradient colors in the water, soft blue and green hues»

prompt = «soft dreamy macro of purple wildflowers, pastel tones of pink and green, bokeh background, airbrush texture, gentle grain, ethereal glow, abstract floral photography aesthetic»

Итоговые генерации

После уточнения промтов и подбора более точных референсов мне удалось добиться нужного результата и приблизить изображения к задуманной эстетике, нежной, чуть наивной, расплывчатой и абстрактной.

prompt = «cute pastel illustration with smiling cartoon animals, soft glowing trees and flowers, gradient airbrush effect, vaporwave aesthetic, mint green and pink tones, dreamy soft light background»

prompt = «childlike airbrush abstract childlike drawing of animals dancing under the sun, uneven proportions, bright pastel colors, airbrush texture, naive silly art style, glowing joyful atmosphere»

prompt = «cute pastel illustration with smiling cartoon animals, soft glowing trees and flowers, gradient airbrush effect, vaporwave aesthetic, mint green and pink tones, dreamy soft light background»

prompt = «playful airbrush illustration of a cat with tiny body and giant head, simple cartoon shapes, pastel pink and blue tones, childish naive drawing, uneven lines and funny expression»

Чему удалось обучить нейросеть?

В ходе обучения модель освоила новое стилевое направление, основанное на собранных референсах и описаниях, близких к технике airbrush.

Несмотря на ограниченный датасет и небольшое количество шагов, нейросеть всё же смогла усвоить ряд визуальных закономерностей, характерных для выбранного направления.

Модель научилась передавать общие черты и атмосферу изображения: переходы цвета стали более сглаженными; появилась воздушная, «дымчатую» светотень, характерная для аэрографии; ощущение свето-сияния, источники света, отражения и неоновые оттенки часто выглядят «свежо» и слегка размыто, что создаёт эффект свечения.

Даже при разной тематике изображения присутствует характерная мягкость, что является главным признаком, что модель начала улавливать airbrush стилистику.

Нейросеть усвоила использование пастельных и плавно смешанных тонов, тяготение к голубым, розовым, сиреневым и бирюзовым оттенкам, уменьшение контраста между элементами сцены (цвета начинают перетекать друг в друга)

Такой эффект цветового рассеевания результат того, что на многих референсах использовались нежные градиенты без резких границ.

LoRA-обучение позволило передать текстуру и поверхности. Поверхности стали гладкими, с лёгким свечением с изменением промыта.

То есть, модель не просто запомнила картинки, а действительно начала применять эти текстурные закономерности при генерации новых изображений.

Модель также научилась переносить стилистику на разные сцены. Даже если в Промте идет речь о портрете, городе или звёздном небе, характерная «дымчатая» мягкость сохраняется.

То есть обучение не ограничилось запоминанием конкретных кадров нейросеть смогла обобщить стиль и применить его к новым контекстам.

Как итог, мы видим ярко выраженный стиль на уровне цвета, света. На уровне сюжетный и композиционных паттернов есть частично выраженный стиль, однако пока не удалось достигнуть узнаваемости конкретного авторского почерка из-за малого датасета и короткого обучения.